圖文變4秒短片 開放試玩 Stability AI推視訊生成模型

原文刊於信報財經新聞「EJ Tech 創科鬥室」

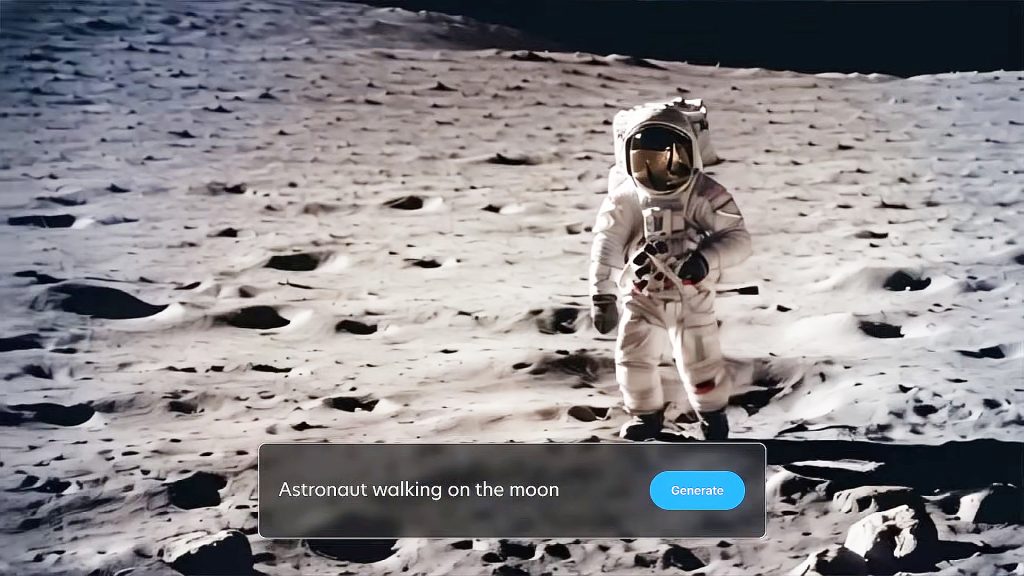

英國初創Stability AI周二在網站宣布,推出視訊生成模型Stable Video Diffusion(SVD)。從示範效果可見,用戶可從文字或圖像生成短片,例如輸入「太空人在月球漫步」、「大廈天台站了兩隻藍雀」等,即可生成約4秒的短片。模型程式碼已放在軟件代碼託管平台GitHub,以及人工智能(AI)社區HuggingFacee供開源研究。

Stable Video Diffusion以穩定擴散(Stable Diffusion)影像模型為基礎,並提供SVD及SVD-XT兩種模型形式,兩者都能以每秒3到30幀速度生成影片,其中SVD可以把靜態影像,轉換成每秒14幀的短片,解像度為576×1024像素;SVD-XT採用相同的架構,惟速度進一步增至24幀。模型本身亦有技術限制,例如生成的片段相當短,取景以慢鏡平移為主,無法渲染文字或清晰臉孔等。

語音版ChatGPT免費使用

綜觀「文字到影片」(Text-to-Video)平台,市場其實不乏同類選擇,例如Meta Platforms旗下Make-A-Video,以至谷歌(Google)開發的Imagen Video等。Stability AI強調在用戶偏好研究中,向人類評分者展示網站生成的短片,再根據畫質及提詞符合程度評分,認為新模型表現勝過RunwayML、Pika Labs等商業模型,在廣告、教育、娛樂等領域具發展潛力。

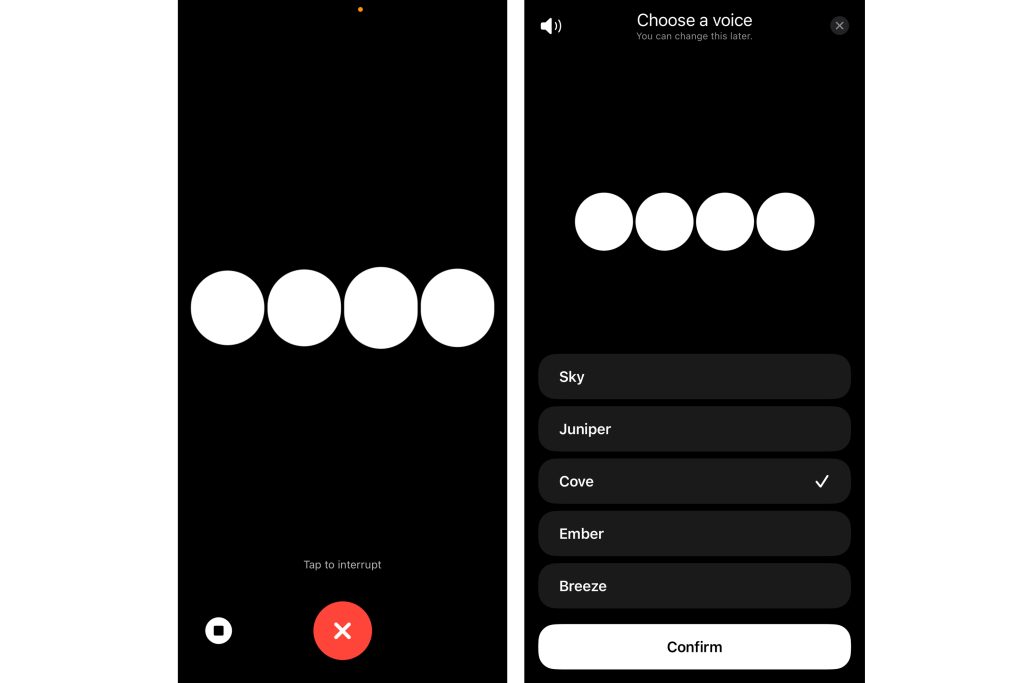

大型語言模型方面,美企OpenAI即日起向所有用戶免費開放語音版ChatGPT功能,在手機下載應用程式後,再點擊耳機圖示即可對話,有5種人聲設定可供選擇。以外賣16吋意式薄餅為例,若問及OpenAI全公司的778人,每人至少要吃3塊才飽,那該訂購多少薄餅才夠,ChatGPT隨即回答:195個薄餅。

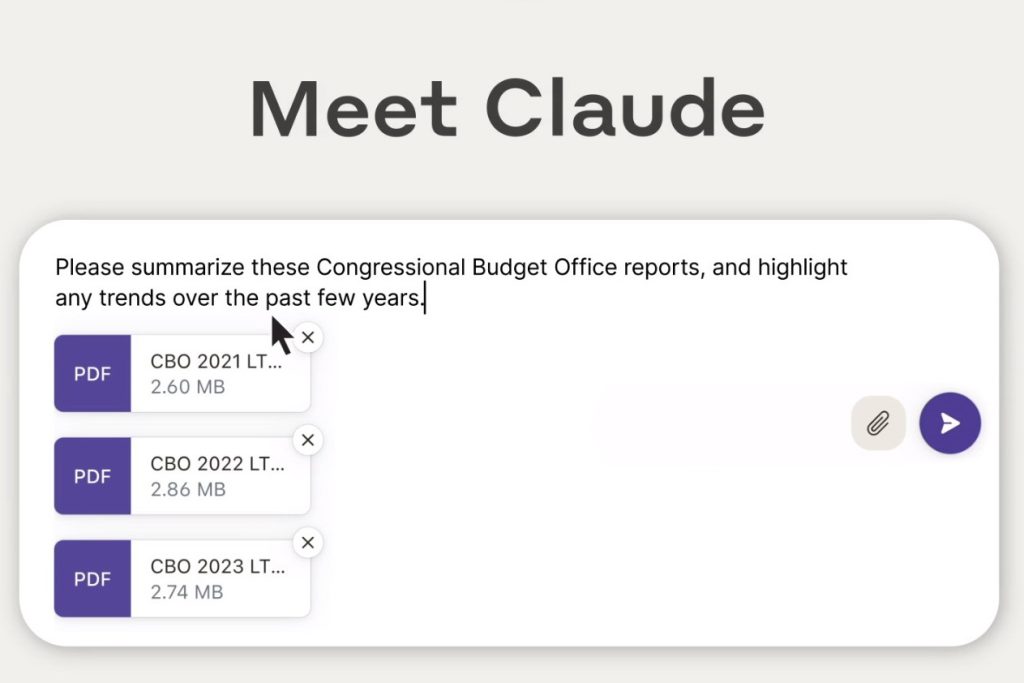

Claude 2.1一次入500頁內容

繼OpenAI早前公布最新版GPT-4支援128K脈絡(Context Window),其主要對手Anthropic亦不甘後人,剛發布聊天機械人Claude 2.1 200K版本,能夠一次輸入約15萬個英文字(大概500頁紙)的內容,足以上傳及分析整份技術文件、冗長財務報告,甚至長篇文學作品,比起2.0的100K Context Window多了一倍,錯誤及「幻覺」問題均有顯著改善。

Anthropic提醒,開發人員可以把Claude模型連接到現有的公司應用程式介面(API)、數據庫及Web服務。定價方面,以每輸入100萬個Tokens計算,提詞(Prompt)部分收費8美元(約62.4港元),完成(Completion)部分收費24美元(約187.2港元)。模型即日起於Claude.ai網站免費試用,本港用戶必須使用VPN(虛擬私人網絡)才可訪問。

支持EJ Tech

如欲投稿、報料,發布新聞稿或採訪通知,按這裏聯絡我們。

如欲投稿、報料,發布新聞稿或採訪通知,按這裏聯絡我們。