科泓科技|AI聲紋配音 保留角色神髓

原文刊於信報財經新聞「CEO AI⎹ EJ Tech」

由香港貿易發展局主辦的香港國際影視展(FILMART)及亞洲影視娛樂論壇 (EntertainmentPulse)日前閉幕。本屆博覽以「敢變,敢精采」為主題,首設「人工智能影坊」(AI Hub)試點項目,重點展示AI技術在前期製作及拍攝、影像及聲紋製作,以及虛擬製作三大領域的應用。

AI Hub參展商之一、香港電影後期專業人員協會代表鄭名輝現場向記者展示一段2022年上畫港產電影的片段,記者正疑惑箇中奧妙時,他才告知片段中兩位主演的聲音均由AI生成。而在另一段影片中,主演的聲線依然跟真人無異,卻操着一口流利泰語,口型亦能同步配合。

電影對白翻譯不同語言

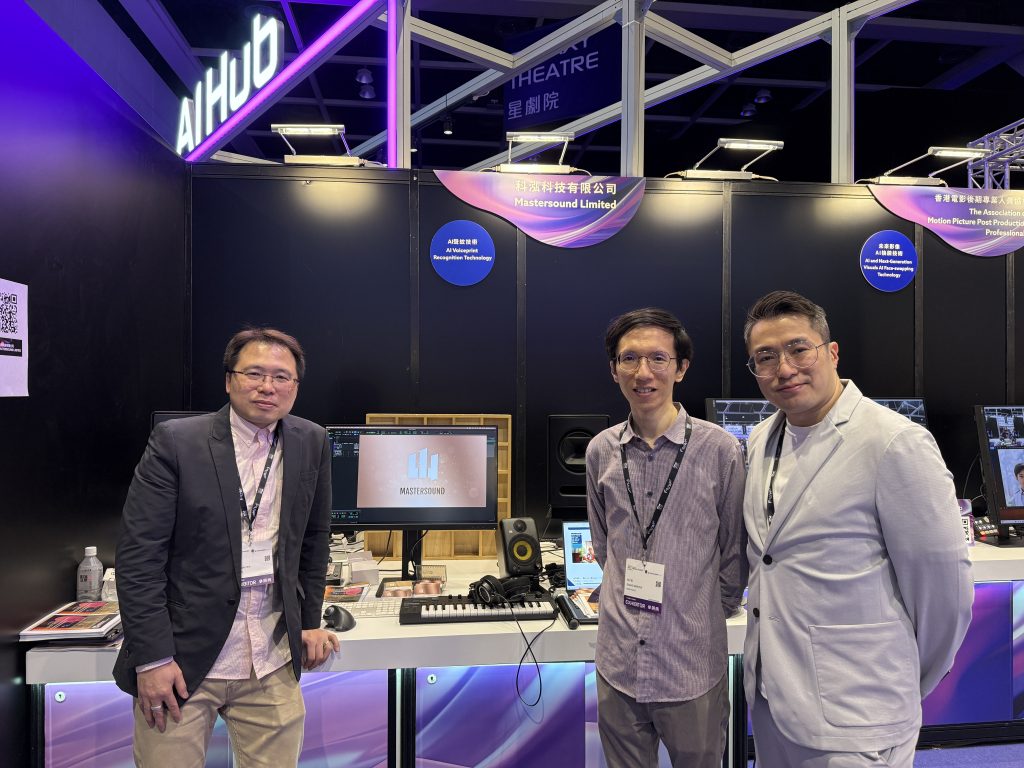

由鄭名輝跟兩位拍檔張子堅、謝禧文共同創辦的科泓科技有限公司(MASTERSOUND LIMITED),提供的正是上述服務。鄭名輝介紹,團隊技術一方面能嚴格比照原生角色聲紋,為其更新及補配對白;另一方面可直接把電影對白翻譯成不同語言,再轉換成原生角色聲紋。團隊的最終目標是實現於自動翻譯電影配音之餘,保留原生角色的聲音、聲調、語氣及感情。

坊間免費文字轉語音(Text-to-Speech, TTS)平台五花八門,鄭名輝直言,這類工具弱點之一是音頻清晰度過低,遠未能滿足出品要求的24bit/48khz級別音質。若應用在電影中,很容易出現所謂的「彈弓聲」。

17小時數據還原任何人物

音質只是基礎,還原電影實際場景才是關鍵。鄭名輝指出,普通工具雖可應付如新聞播報等語氣起伏不大的內容,但難以精準呈現角色情感。相比之下,自家技術的優勢在於對細節的高度還原,例如爭吵時的語調變化、句與句之間的換氣聲等。他坦言,最終成品的效果,仍取決於訓練模型的音頻數量與質素。若數據質素良好,約17小時的音頻便足以應對所有配音需求,「嗰個人以後都唔使再配音了」。

鄭名輝進一步解釋,若要訓練能識別語調與聲紋對應關係的AI模型,首先需收集涵蓋各類情緒的語音數據,然後挑選合適的配音員,確保其語音樣本能精準呈現情感特徵。完成訓練後,模型可在偵測新語音時,依據語調自動匹配適當聲紋。這一系列操作能確保成果不僅音質相似,還保留原有的情感。

提到生成式AI在影視製作中的應用,鄭名輝認為,除了「生成100次,先中到兩次心意」這一弊病外,無法針對特定細節作修改才是其最大短板。以人手修改勢必影響畫質;而讓AI重新生成後的成果,又往往跟上一版本相去甚遠,難以精準控制。

支持EJ Tech

如欲投稿、報料,發布新聞稿或採訪通知,按這裏聯絡我們。

如欲投稿、報料,發布新聞稿或採訪通知,按這裏聯絡我們。